Inteligencia de Datos Para Todos: 9 Formas en que Databricks Redefinió el Futuro de los Datos

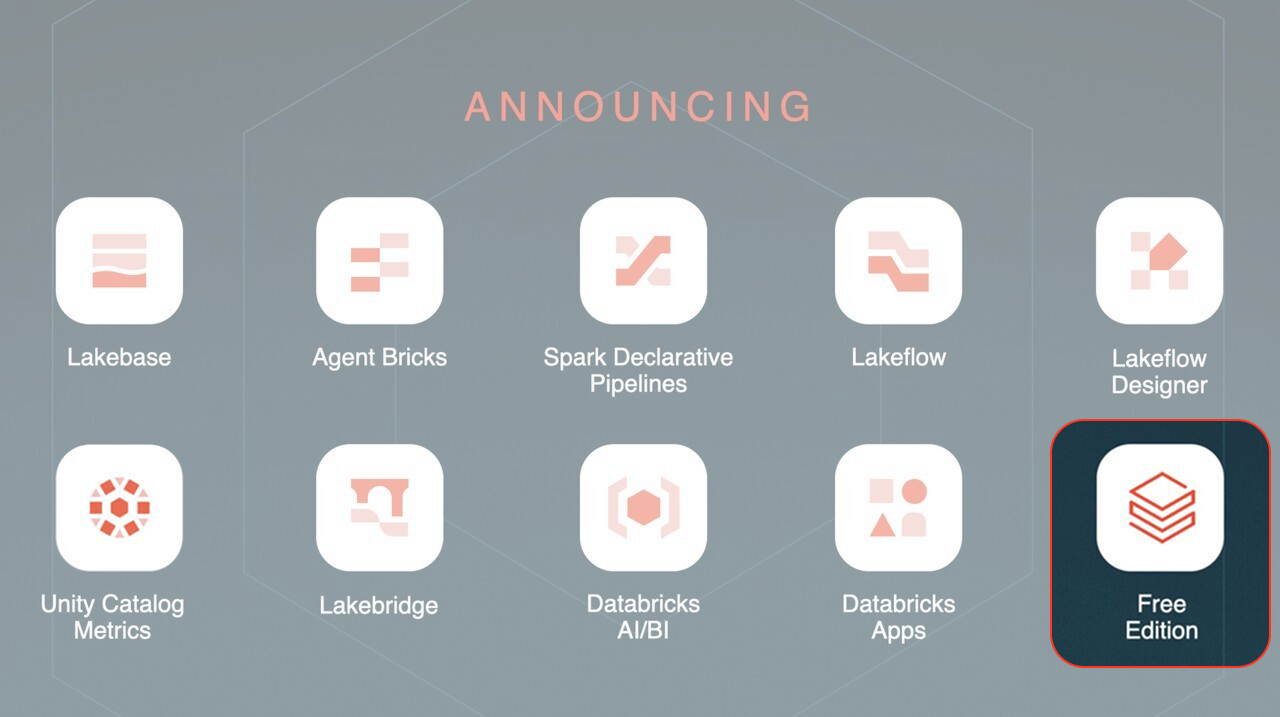

El Data+AI Summit 2025 de Databricks trajo numerosos anuncios que refuerzan la visión del Lakehouse unificado que integra datos e inteligencia artificial. A lo largo del evento se presentaron innovaciones clave que marcan el rumbo de la plataforma.

A continuación resumimos los principales anuncios:

Lakebase: Transacciones integradas en la era de la IA

Databricks Lakebase es una nueva base de datos transaccional totalmente gestionada (OLTP), construida sobre PostgreSQL y profundamente integrada con el Lakehouse. Surge para superar las limitaciones de las bases de datos operacionales tradicionales, que suelen estar aisladas de la plataforma analítica y requieren integraciones manuales poco flexibles.

Lakebase adopta una arquitectura moderna con separación de cómputo y almacenamiento, lo que permite escalar de forma independiente y soportar características avanzadas como branching (clonación de entornos). Al estar integrada con el ecosistema Databricks, permite conectar directamente los datos transaccionales con la analítica y la IA, acelerando la entrega de aplicaciones inteligentes.

💼 Por qué importa para el negocio: Lakebase facilita la creación de aplicaciones operativas AI-native sin salir de la plataforma unificada, reduciendo la complejidad de arquitectura y garantizando que los datos críticos estén fácilmente integrados para su análisis.

Más información: Anuncio de Lakebase Public Preview | ¿Qué es Lakebase?

Agent Bricks: Agentes de IA auto-optimizados con sus datos

Agent Bricks es una nueva herramienta que simplifica radicalmente el desarrollo de agentes de IA generativa (chatbots, asistentes, etc.) especializados en los datos de su empresa. En lugar de tener que ajustar manualmente cientos de parámetros y probar sin cesar, con Agent Bricks basta describir en lenguaje natural la tarea o dominio, y la plataforma se encarga automáticamente de la evaluación y ajuste fino del agente.

Esta solución, respaldada por la investigación de Mosaic AI de Databricks, optimiza los agentes para lograr mayor calidad a menor costo – por ejemplo, elige el mejor prompt, modelo o técnica de fine-tuning para su caso. Ya ha sido probada en producción por empresas como Flo Health o AstraZeneca para desplegar agentes de IA precisos y confiables en días en lugar de semanas.

💼 Por qué importa para el negocio: Agent Bricks reduce la barrera para incorporar IA conversacional o asistentes inteligentes en productos y procesos de negocio, al automatizar las partes más complejas de la construcción y optimización. Esto permite a las organizaciones poner agentes de IA en producción más rápido, con métricas de calidad controladas y alineados a objetivos de negocio, sin necesidad de un ejército de expertos en LLM tuning.

Más información: Introduciendo Agent Bricks

Databricks Apps: Plataforma de aplicaciones de datos e IA dentro del Lakehouse

Ahora es posible crear y desplegar aplicaciones interactivas de datos e IA directamente en Databricks gracias a los nuevos features de Databricks Apps. Esta plataforma de app hosting integrada permite a los equipos de datos y desarrolladores construir rápidamente aplicaciones personalizadas – paneles interactivos, aplicaciones de IA generativa como chatbots corporativos (RAG apps), herramientas de análisis de autoservicio, etc. – todo dentro del entorno gobernado de Databricks.

Al abstraer la infraestructura (es serverless y seguro por diseño), Databricks Apps elimina la necesidad de mover datos a aplicaciones externas, manteniendo la gobernanza y reduciendo riesgos de duplicación o fuga de datos. Desde su preview el año pasado ya se han creado más de 20 mil apps con esta plataforma, demostrando el interés por simplificar la entrega de aplicaciones de datos.

💼 Por qué importa para el negocio: Con Databricks Apps, las empresas pueden ofrecer soluciones internas y de cara al cliente más rápido, aprovechando los datos centralizados. Un equipo de analítica ahora podría desarrollar, por ejemplo, un portal de indicadores o una aplicación de IA para clientes sin desplegar servidores aparte, logrando time-to-market más corto y asegurando que los datos utilizados siempre estén bajo control y actualizados.

Más información: Anuncio de Disponibilidad General de Databricks Apps | Documentación de Databricks Apps

Databricks One: Datos y IA al alcance de los ejecutivos

Dirigido a usuarios de negocio no técnicos, Databricks One es una nueva experiencia de usuario unificada y simplificada para que C-levels y analistas accedan al valor del Lakehouse con la menor fricción posible. Esta interfaz, con diseño renovado, permite que los líderes corporativos consuman dashboards de BI y resultados de IA, formulen preguntas en lenguaje natural mediante el asistente AI/BI Genie, y utilicen aplicaciones de datos creadas en la plataforma – todo desde un mismo lugar.

AI/BI Dashboards y Genie: Inteligencia Accesible

Central a la experiencia Databricks One están las capacidades AI/BI que hacen la inteligencia de datos verdaderamente accesible para usuarios de negocio:

AI/BI Dashboards proporciona una solución de inteligencia de negocio de bajo código potenciada por IA con:

Interfaz sin código, drag-and-drop para crear visualizaciones interactivas

Capacidades integradas de programación y exportación para reportes operacionales

Filtrado cruzado y alta interactividad que permite exploración dinámica de datos

Integración profunda con Unity Catalog asegurando acceso gobernado a datos confiables

AI/BI Genie ofrece una interfaz conversacional que transforma cómo los usuarios de negocio interactúan con los datos:

Consultas en lenguaje natural: Haga preguntas de negocio en español y obtenga insights instantáneos

Respuestas multimodales: Recibe respuestas vía resúmenes de texto, tablas y visualizaciones

Aprendizaje continuo: Recuerda aclaraciones y mejora las respuestas con el tiempo

Enfoque de IA ensemble: Aprovecha múltiples agentes de IA especializados y LLMs para precisión

En esencia, Databricks One convierte la plataforma en un portal empresarial de datos e inteligencia artificial, donde un directivo puede consultar indicadores, explorar insights o interactuar con un chatbot de análisis, sin requerir conocimientos técnicos profundos. Estará disponible en beta pública en el verano de 2025 y promete acercar aún más la ciencia de datos al front-office.

💼 Por qué importa para el negocio: Esto democratiza el acceso a datos e IA para la toma de decisiones. Los usuarios corporativos ganan autonomía para obtener respuestas y visualizar información en tiempo real, mientras el departamento de datos mantiene la seguridad y la gobernanza. En la práctica, Databricks One puede impulsar una cultura más data-driven, donde las decisiones de negocio se toman con insights rápidos y confiables, sin cuellos de botella ni interpretación ambigua de resultados. Las capacidades AI/BI específicamente abordan el desafío persistente de hacer analítica avanzada accesible a usuarios no técnicos, potencialmente eliminando la necesidad de herramientas de BI separadas y reduciendo la complejidad del stack analítico.

Más información: Blog Introducción de Databricks One | Página de AI/BI Genie

Edición Gratuita de Databricks: Lakehouse para todos, sin costo

En una apuesta por democratizar el aprendizaje y la adopción de Data & AI, se lanzó la nueva Databricks Free Edition, una versión gratuita del workspace de Databricks con casi todas las funcionalidades de la edición Enterprise. Cualquier persona (estudiantes, desarrolladores, startups) puede aprender y experimentar en la misma plataforma que usan millones de profesionales, sin pagar nada.

Esta edición free, basada totalmente en arquitectura serverless, incluye una amplia gama de features que antes solo estaban disponibles para clientes de pago, permitiendo practicar desde SQL analytics hasta machine learning en un entorno de nivel empresarial. Además, Databricks Academy ha liberado todos sus cursos autodirigidos de forma gratuita, para atender la creciente demanda de talento en datos e IA.

💼 Por qué importa para el negocio: Esta iniciativa ampliará el ecosistema de usuarios familiarizados con Databricks a la vez que permitirá a organizaciones explorar la plataforma sin barreras de costo, fomentando la innovación y prototipado rápido en equipos pequeños antes de escalar. En suma, aumenta la accesibilidad a tecnologías punteras de datos/IA, algo crítico en un contexto donde la ventaja competitiva depende del talento y la experimentación constante.

Más información: Introduciendo Databricks Free Edition | Comenzar con Free Edition

MLflow 3.0: MLOps unificado para la IA generativa y tradicional

Databricks anunció MLflow 3.0, una evolución significativa de su plataforma de MLOps abierta, ahora orientada a integrar plenamente los casos de IA generativa (GenAI) junto con el machine learning tradicional. MLflow 3.0 unifica el desarrollo de modelos de ML clásico, deep learning y aplicaciones de GenAI en una sola plataforma, eliminando la necesidad de herramientas especializadas independientes.

Incorpora nuevas capacidades diseñadas para los desafíos de IA generativa, como trazabilidad a escala de producción de las ejecuciones (registro de prompts, salidas, costos y latencia), un sistema renovado de evaluación de calidad con jueces LLM, mecanismos para recolección de feedback humano, y un versionado completo de prompts y aplicaciones de IA. Esto permite un ciclo de vida completo: depurar con traces, medir calidad automáticamente, mejorar con feedback experto, rastrear cambios y monitorizar todo en producción.

💼 Por qué importa para el negocio: Con MLflow 3.0, las organizaciones obtienen un estándar de facto para gobernar tanto sus modelos predictivos tradicionales como sus nuevos agentes generativos. La plataforma ofrece observabilidad y control exhaustivo sobre sistemas de IA antes opacos (ej. chatbots), ayudando a detectar sesgos, alinear comportamientos y cumplir requisitos de calidad y cumplimiento. En la práctica, un equipo de datos puede iterar más rápido en aplicaciones de lenguaje natural con la tranquilidad de contar con métricas, versiones y auditoría igual que lo haría con un modelo de ML convencional .

Más información: MLflow 3.0: Experimentación, Observabilidad y Gobernanza de IA Unificada

Lakeflow y Lakeflow Designer: Ingeniería de datos unificada (ingestión, ETL, orquestación)

Para abordar la complejidad de los pipelines de datos en la empresa, Databricks lanzó Lakeflow, su solución unificada de ingeniería de datos que engloba ingestión, transformación y orquestación en la plataforma Lakehouse. Lakeflow reemplaza la necesidad de combinar herramientas dispares de ETL, streaming, schedulers, etc., ofreciendo una solución de extremo a extremo nativa de Databricks.

Con Lakeflow, los equipos pueden encargarse de todas las fases del pipeline en un solo framework, con gobernanza y monitoreo integrados – por ejemplo, integración con Unity Catalog para trazabilidad y controles de acceso unificados.

La plataforma incluye componentes dedicados: Lakeflow Connect (conectores gestionados de ingestión para bases de datos, aplicaciones empresariales, archivos y streams en tiempo real), Lakeflow Declarative Pipelines (pipelines escalables basados en el nuevo estándar abierto Spark Declarative Pipelines, integrado con un IDE moderno para desarrollo ETL) y Lakeflow Jobs (orquestación nativa con flujos de control avanzados, disparadores en tiempo real y monitorización completa).

Adicionalmente, se presentó Lakeflow Designer, una interfaz visual no-code con soporte de drag-and-drop y lenguaje natural para construir pipelines de datos de calidad producción sin escribir código. Lo diseñado en esta herramienta se traduce automáticamente en pipelines declarativos gobernados por Lakeflow, permitiendo que analistas de negocio y data engineers colaboren sin necesidad de rehacer trabajos.

Spark Declarative Pipelines: Innovación Open Source

Como parte del anuncio de Lakeflow, Databricks también reveló su compromiso con el open source al donar su framework declarativo de ETL central a Apache Spark como Spark Declarative Pipelines. Esta tecnología probada en batalla, que ha potenciado miles de workloads de clientes durante más de tres años, ahora estará disponible para toda la comunidad Apache Spark.

Capacidades clave:

Ganancias dramáticas de productividad: Empresas como Block redujeron el tiempo de desarrollo en más del 90%, mientras que Navy Federal Credit Union redujo el tiempo de mantenimiento de pipelines en un 99%

Batch y streaming unificados: Un solo framework maneja tanto reportes batch diarios como aplicaciones de streaming de sub-segundo

Enfoque declarativo: Los ingenieros describen qué debe hacer su pipeline usando SQL o Python, y Spark maneja la ejecución automáticamente

Probado empresarialmente: Construido sobre el motor Spark Structured Streaming con seguimiento automático de dependencias, checkpointing y manejo de errores

💼 Por qué importa para el negocio: Lakeflow elimina la costosa fragmentación de herramientas de datos, reduciendo el overhead de integrar y mantener múltiples plataformas. Esto se traduce en ahorros de costo y tiempo, ya que una sola solución se encarga de la ingesta de datos (con una creciente biblioteca de conectores), las transformaciones (SQL o Python declarativo) y la orquestación confiable de pipelines. Con Lakeflow Designer, más personas en la organización pueden participar en la creación de flujos de datos (por ejemplo, un analista construyendo un pipeline inicial) manteniendo las mejores prácticas, ya que el sistema guía con inteligencia incorporada y todo queda bajo las mismas políticas de gobierno. Lakeflow agilizará la entrega de datos listos para análisis o modelos, permitiendo a los equipos enfocarse en aportar valor al negocio en lugar de lidiar con infraestructuras complejas.

Más información: Página del Producto Lakeflow | Blog de Spark Declarative Pipelines

Soporte nativo a Apache Iceberg: formatos abiertos bajo gobierno unificado

En el ámbito de la gestión de datos, Databricks anunció soporte completo para Apache Iceberg en su plataforma, marcando un hito hacia la eliminación de bloqueos por formato de tabla. Unity Catalog (el catálogo unificado de Databricks) ahora permite crear y manejar tablas Iceberg gestionadas (Managed Iceberg Tables) dentro de Databricks, así como leer y escribir esas tablas desde motores externos utilizando la API REST de catálogo Iceberg .

Estas tablas Iceberg gestionadas se benefician de optimizaciones automáticas (por ejemplo, auto-clustering de datos para rendimiento) y funcionan de forma similar a las tablas Delta, integrándose con características avanzadas de la plataforma como consultas SQL, MosaicML, Delta Sharing o materialized views.

Además, Unity Catalog ahora puede federar metadatos de Iceberg de catálogos externos (AWS Glue, Hive Metastore, Snowflake, etc.), permitiendo gobernar y consultar desde Databricks tablas Iceberg que residen fuera, sin necesidad de migrarlas. Todo esto impulsa la visión de un Lakehouse verdaderamente abierto, donde los datos pueden estar en Delta Lake o Iceberg de manera intercambiable, bajo un mismo paraguas de seguridad y gobernanza.

Unity Catalog Metrics: Semántica de Negocio Unificada

Más allá del soporte de formatos de tabla, Unity Catalog ahora aborda uno de los desafíos más persistentes en la gestión de datos empresariales con Unity Catalog Metrics (Public Preview, GA este verano). Esta capacidad hace que las métricas de negocio y KPIs sean activos de primera clase en el lakehouse, eliminando la confusión y desalineación causada por definiciones inconsistentes de métricas entre equipos y herramientas.

Enfoque:

Definir una vez, usar en todas partes: Crear métricas una vez en Unity Catalog y usarlas en AI/BI Dashboards, Genie, Notebooks, SQL y trabajos de Lakeflow

Direccionables por SQL: A diferencia de las métricas atrapadas en capas semánticas de BI, Unity Catalog Metrics son completamente accesibles vía SQL desde cualquier herramienta

Gobernado por defecto: Las métricas certificadas vienen con auditoría, linaje y controles de acceso granulares listos para usar

Integraciones próximas: Soporte planificado para herramientas de BI como Tableau, Hex, Sigma, ThoughtSpot, y herramientas de observabilidad como Anomalo y Monte Carlo

💼 Por qué importa para el negocio: Esta compatibilidad con Iceberg ofrece mayor flexibilidad arquitectónica y evita el “encierro” en un solo formato. Las empresas pueden adoptar Databricks sin temor a quedar atadas a un formato propietario, ya que pueden elegir el formato de tabla óptimo para distintos casos de uso (por ejemplo, Iceberg para integración con ciertas herramientas open source, Delta para otras) sin perder el control centralizado.

También facilita estrategias multi-cloud o híbridas, al poder unificar el acceso y gobierno de datos dispersos en distintos sistemas. En definitiva, es una garantía de que la plataforma Lakehouse abraza estándares abiertos, algo valioso para los líderes de TI al planificar a largo plazo su infraestructura de datos.

Más información: Documentación de Unity Catalog | Sesión Unity Catalog Metrics | Soporte Apache Iceberg

Lakebridge: Migración acelerada desde data warehouses legados

Finalmente, para las organizaciones que aún operan data warehouses tradicionales y desean modernizarse, se introdujo Lakebridge (antes BladeBridge). Este componente gratuito automatiza hasta un 80% de las tareas en un proceso de migración de un data warehouse legado hacia el Lakehouse de Databricks.

Lakebridge ofrece soporte de punta a punta: perfilado y evaluación del sistema origen, conversión automatizada de SQL y objetos (por ejemplo, pasar códigos SQL propietarios a SQL estándar sobre Databricks), validación y reconciliación de datos para asegurar que los resultados coinciden, todo con mínima intervención manual. En la práctica, la herramienta puede duplicar la velocidad de migración respecto a métodos tradicionales, simplificando lo que típicamente es un proyecto complejo y propenso a errores.

💼 Por qué importa para el negocio: Lakebridge ayuda a acelerar la transformación digital al facilitar la migración de plataformas analíticas antiguas hacia la arquitectura moderna del Lakehouse. Para un CIO o CTO, esto significa menos costo y riesgo al migrar décadas de datos y lógica de negocio, y una transición más rápida hacia un entorno unificado de datos e inteligencia artificial. Al automatizar lo pesado (ej. Con la conversión de cientos de procedimientos SQL), el equipo puede enfocarse en re-diseñar las soluciones con mejores prácticas y no en tareas repetitivas, consiguiendo que la organización aproveche antes los beneficios de escalabilidad y flexibilidad del Lakehouse.

Conclusión

En conjunto, estos anuncios subrayan la estrategia de Databricks de ofrecer una plataforma integral de datos e IA que sea abierta, escalable y enfocada en casos de negocio. Para los líderes empresariales, las novedades significan: infraestructuras más simples (menos silos de datos y menos herramientas aisladas), mayor agilidad para desarrollar soluciones de IA y analytics, y la capacidad de gobernar todo el ciclo de vida de datos y modelos con confianza.

Tecnologías como Lakebase y Lakeflow indican que incluso las cargas operacionales y de ingeniería de datos más complejas ahora pueden convivir nativamente con la analítica avanzada; herramientas como Agent Bricks y MLflow 3.0 muestran cómo la IA de última generación puede implementarse con rigor y rapidez; y características como Databricks One o Free Edition impulsan la democratización del acceso tanto a la plataforma como al conocimiento en datos/IA.

En un entorno competitivo donde “cada empresa es una empresa de datos”, estas innovaciones permitirán a las organizaciones acelerar su camino hacia ser verdaderamente impulsadas por datos e inteligencia artificial, manteniendo el control de sus activos y alineando la tecnología con objetivos estratégicos de negocio.